En este blog se ha hablado más de una vez de las pruebas A/B para mejorar los sitios de comercio electrónico. La forma de entender estas pruebas es a modo de experimento rápido que permite elegir entre dos pequeñas variaciones de una página web: ¿Es mejor poner el carrito de compra a la derecha o a la izquierda? ¿Es mejor ofrecer el registro de usuarios en portada o cuando se ha completado la compra? ¿Funciona mejor un sistema de recomendación automático de productos o una selección «humana»? Las pruebas han de ser sencillas, únicas y en cierto modo «muy binarias»: o una forma u otra.

La forma de resolver estos dilemas no siempre es intuitiva, pero técnicamente es muy sencillo: se preparan y lanzan las dos opciones a los visitantes reales de la web –siempre intentando una variación mínima, no varias a la vez– y se examinan los resultados. Midiendo los efectos que se quieren observar (por ejemplo, el porcentaje de visitas que se convierten en compra, el tamaño de las cestas o el tiempo de visita) se puede tomar una decisión al respecto.

Una compañía como Amazon (que según cuenta la leyenda es quien inventó este tipo de pruebas en eCommerce) puede obtener suficientes datos de sus millones de visitantes en 15 minutos como para tomar una decisión al respecto. Ahora bien, ¿cómo sabemos en una tienda pequeña, con menos visitas y pedidos cuánta gente necesitamos para que la muestra sea significativa?

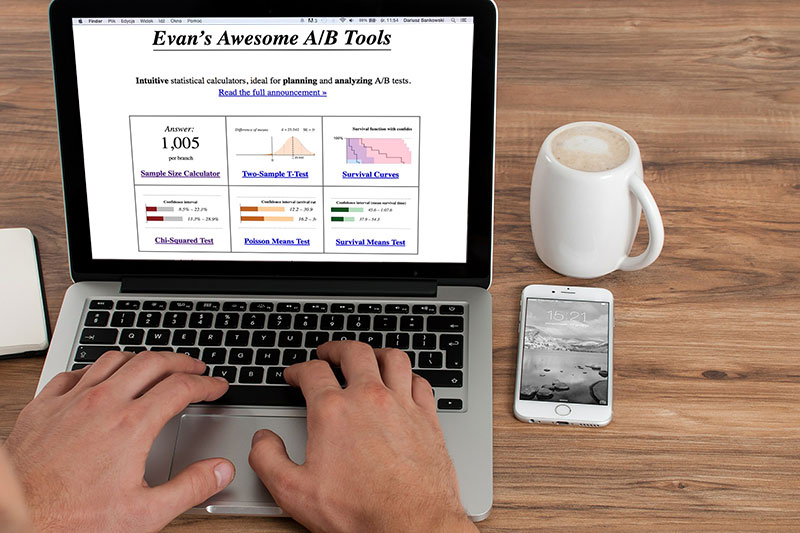

Evan Miller tiene una página en la que preparó varias herramientas estadísticas sobre pruebas A/B que resulta muy visual, fácil de entender e intuitiva.

La prueba básica y más común consiste en preguntarse ¿cuántas visitas hacen falta para realizar una buena prueba A/B? Parece evidente que cuantos más visitantes participen, mejor. Pero, cuál es el mínimo necesario como para que esa prueba sea realista o arroje valores significativos?

La respuesta tan solo requiere dos datos: primero, el ratio de conversión actual (número de «acciones deseadas» dividido por el número de visitas, por ejemplo 5% = 5 personas acaban comprando de cada 100 que visitan la tienda). Segundo, el valor del mínimo efecto detectable expresado como percentil (por ejemplo, un 1% arriba o abajo) -Esto último puede indicarse con los botones absoluto/relativo en términos absolutos, como en el ejemplo o relativos, usando un porcentaje-.

Los últimos valores que hay que indicar requieren saber algo más de estadística pues son el nivel de confianza de la prueba: el valor 1-ß («uno menos beta») indica qué porcentaje de las veces el resultado será correcto suponiendo que el efecto que se intenta detectar exista, mientras que el valor α más bien es lo contrario: el porcentaje de veces que se detectará como correcto un efecto que no existe, lo que suele denominarse «falso positivo». Jugar en la página con todos estos valores es una forma rápida de entender mejor cómo funcionan. Consejo: suele ser conveniente emplear siempre una confianza del 80% o superior y un ratio de falsos positivos del 5% como máximo.

A modo de ejemplo, si se utilizan como valores el 5% de conversión actual, 1% como rango de variación que queremos descubrir (es decir, que el ratio varíe entre 4% y 6%) y se busca un nivel de confianza del 90% admitiendo un 5% de falsos positivos la calculadora da una respuesta precisa: 10.347 visitas. Cueste mucho conseguirlas o poco, ese es el objetivo si se quiere que la prueba valga algo. Cuanto antes se consigan de forma «natural», mejor, claro. Si por alguna razón las visitas son numerosas y se alcanza la cifra en poco tiempo se puede reducir el mínimo efecto detectable para afinar la prueba.

En la página de Miller hay otras herramientas de corte más estadístico todavía más avanzado: test dobles, intervalos de confianza, diferencias en las pruebas… También muy útiles si se tienen los conocimientos estadísticos adecuados para hacer buen uso de ellas.

Nos encantará conocer tu opinión, pero primero tenemos que indicarte que los comentarios están moderados, y no aparecerán inmediatamente en la página al ser enviados. Evita, por favor, las descalificaciones personales, los comentarios maleducados, los ataques directos o ridiculizaciones personales, o los calificativos insultantes de cualquier tipo, sean dirigidos a los autores, a cualquier otro comentarista o la empresa propietaria de esta página. Estás en tu perfecto derecho de comentar anónimamente, pero por favor, no utilices el anonimato para decirles a las personas cosas que no les dirías en caso de tenerlas delante. Intenta mantener un ambiente agradable en el que las personas puedan comentar sin temor a sentirse insultados o descalificados. No comentes de manera repetitiva sobre un mismo tema, y mucho menos con varias identidades o suplantando a otros comentaristas. También, procura que tus opiniones estén relacionadas con lo que se comenta en esta entrada. Los comentarios off-topic, promocionales, o que incumplan todas estas normas básicas serán eliminados.